Experiencia

en la integración de sensores para la estimación de la posición de un robot móvil

en la ejecución del algoritmo Dist-Bug.

En

este trabajo se realiza la integración de sensores para

disminuir el error en la estimación de

la posición de un robot móvil teniendo en cuenta su geometría, el robot móvil en este caso el LEGO Mindstorm NXT 2.0 ejecuta el algoritmo DistBug para la

construcción de rutas de navegación. El

propósito de esta integración, consiste en que el robot tenga una ubicación más

precisa mientras construye una ruta de navegación en tiempo real y libre de

colisiones, que lo lleve desde un punto inicial a un punto final considerando

la geometría del robot, mientras percibe la información del mundo, el cual

asume como incierto, excepto su posición inicial y su posición de final. Para

esta tarea, el robot utiliza sensores de

sonar como elemento de detección a fin de identificar la distribución de los obstáculos y

el sensor de compass para identificar la dirección de la posición actual del

robot mediante la estimación de la posición relativa, bajo estos parámetros comparar

el error que se ha generado al utilizar o no estos sensores sobre la localización

en el espacio.

En esta aplicación el algoritmo DistBug se muestra con un modelo geométrico claro que permita seguir el comportamiento de este algoritmo, dejando claro que el robot tiene una geometría y que ya no es un punto como se establece en trabajos anteriores.

Geometría del Robot

Para aplicar cualquiera de los sensores se debe conocer como utilizarlo y cuales son sus características técnicas ya que la gran mayoría de los sensores se deben calibrar para obtener una medida o un dato mas preciso porque de eso también depende el manejo de la incertidumbre o el error en la localización.

Calibración sensor de sonar

Calibración del sensor de compas (Brújula)

Análisis de Resultados

Análisis de Resultados

Para iniciar el análisis de

resultados primero se creó un modelo ideal de la ruta del algoritmo DistBug,

para tener criterio de una baja incertidumbre y poder hacer el comparativo

entre todos los resultados. Fig.1 y Tabla.1.

|

| Fig.1. |

|

| Tabla.1. |

Los resultados que se

obtienen a través de las pruebas realizadas se ilustran en las tablas de datos.

En primer lugar se analiza los datos

obtenidos de la tabla.2, Con respecto a la tabla.1, se revisa la desviación

estándar entre estas y se obtiene una

gran diferencia en relación con los puntos obtenidos, verificando que existe

incertidumbre y que es necesario aplicar o integrar otro método de estimación

de la posición como solución para

disminuir la incertidumbre, sin embargo aunque es bajo el error se demuestra

que se ha incrementado por la misma rotación de las ruedas.

|

| Tabla.2. |

Luego para el análisis de

resultados de la tabla.2, y la tabla.3, se muestra que hay una diferencia entre las incertidumbres ya que la comparación

se hace entre los datos adquiridos por un solo método de localización como es

el de odometria que sugiere que se le aplique otro método de localización para

mejorar y disminuir esa diferencia, al observar la tabla.3,

se muestra que hay una incertidumbre menor que la de la tabla.2, ya que en esta se utilizó dos métodos de localización y por lo tanto mejora los resultados obtenidos.

|

| Tabla.3. |

se muestra que hay una incertidumbre menor que la de la tabla.2, ya que en esta se utilizó dos métodos de localización y por lo tanto mejora los resultados obtenidos.

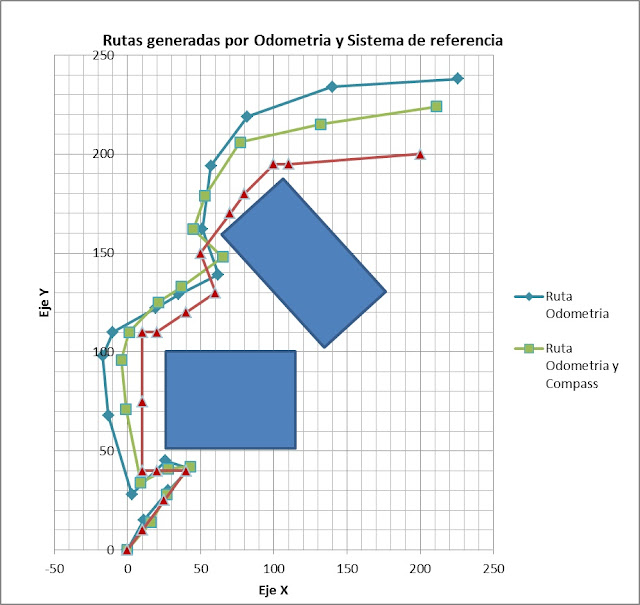

Finalmente se debe comparar los resultados

obtenidos entre el modelo ideal y el modelo de fusión de datos, en este se

aprecia que hay una diferencia menor del error entre los datos por lo que se

considera que son resultados esperados y que muestran que es necesario integrar

varios métodos de localización para llegar a un modelo ideal en la estimación

de la posición. Fig.2.

|

| Fig.2. |

Teniendo en cuenta los resultados

obtenidos, la desviación estándar muestra que el error es significativo si no

se hace una fusión de datos, por lo tanto las rutas generadas por la

información adquirida no será confiable y más aún en un mundo real se presentara

colisiones entre el robot móvil y obstáculos por lo que es obligatorio la

inclusión de nuevos sensores en los robots para obtener un mejor resultado en

ubicación o localización en el espacio.

Lo siguiente indica que los errores en la

rotación se incrementan si solo dependen de pocos sensores. Fig.3.

|

| Fig.3. |

Esto se demuestra por la orientación que

tiene el error debido al desplazamiento del robot móvil, que las ruedas son un

factor importante en la localización por lo que existirá un error constante si

no se realiza una fusión de datos más amplia ósea se incluyan más sensores para

mejorar la estimación de la posición relativa.

Conclusiones

- Se debe tener en cuenta los dos tipos de errores como los son los errores sistemáticos y no sistemáticos para la localización de un robot móvil. Esto se tiene solo en cuenta en modelos reales con obstáculos donde todo tiene incertidumbre y lo cual genera estimadores de posición muy poco confiables por lo que es necesario la inclusión de nuevos sensores para tener otros sistemas de referencia que puedan disminuir la incertidumbre o el error en la ubicación del robot móvil en el espacio.

- Existirá por más sensores o métodos de localización integrados o fusionados siempre un error sistemático y no sistemático, que no se puede manejar pero si disminuir, por lo anterior se puede definir que la estimación de la posición es un tema muy amplio para tratar y no es fácil de implementarlo debido a las diferentes variables que afectan el mundo real.

- Bajo este criterio se indica que un trabajo futuro debe enfocarse más en elaborar un estudio más detallado de las variables que afectan robot en su desplazamiento, teniendo en cuenta que estas variables son errores los cuales, se les debe brindar una solución adecuada para optimizar esa ruta generada.

Escrito por: Diego Fernando Marquez Betancur. Grupo SINTELWEB. Universidad Nacional de Colombia Sede Medellín.